华为携手钢琴家郎朗,想为你演奏一场个人专属的VR音乐会

《纸牌屋》有一句话我挺喜欢:“每个人都无法拒绝自己真实的快乐。你会情不自禁地在自己喜欢的事情上花时间,不知不觉地放一万个小时在那里。时间久了,你就会与众不同。”

当我脑中浮现这句话的时候,我正在听一场VR(虚拟现实)音乐会。

今天下午,在华为VR音乐媒体沟通会上,郎朗首部VR音乐作品正式上线华为视频VR专区和华为VR视频。在现场的体验区,坐上座舱,戴上VR眼镜,就开始了个人专属的音乐会,仿佛郎朗在面前弹奏,不知不觉放松下来听了一会。

说到底,感官所带来的体验虽然短暂,然而我们依然愿意花时间听一首歌,看一场演唱会,看一部电影,或许是因为这些体验真实且丰富。而在华为看来,通过VR音乐,把传统音乐会变成具备3D空间的音乐效果和VR视觉体验,同样也是想用技术营造出一种「现场感」和「沉浸感」。

VR音乐:一场让更多人沉浸的潮流狂欢

借助5G、云计算与AI技术,VR产业正进入快速发展期。随着硬件设备的不断完善,丰富的内容和应用场景,成了推动VR更广泛落地的关键要素。而在数字化时代,人们对文娱生活方式的体验要求不断升级。这两者结合产生的「VR音乐」成为音乐产业的一个潮流走向。

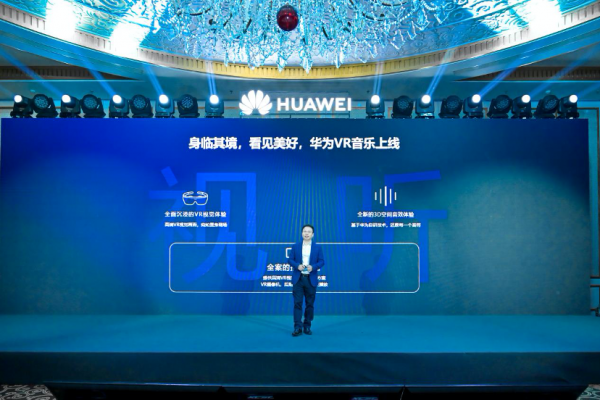

华为消费者云服务副总裁谭东晖在沟通会上指出:“VR会成为5G时代第一波创新应用。”一方面,VR技术走向成熟期、VR硬件设备出货量猛增,2020年全球VR头戴设备的出货量达到670万台,相比2019年增长了72%,基本翻翻。

另一方面去年的特殊情况改变了人们的生活习惯,2020年对在线视频的需求大幅增长,观看时长同比增长40%。消费者需要更多形式、更高品质的优秀内容。

图:华为消费者云服务副总裁谭东晖

华为去年在开发者大会正式发布「VR音视频平台」,经过一年时间,该平台已经取得商用成果,即本次与郎朗发布的VR音乐作品以及其他艺人的共24首曲目。华为VR音视频产品总监Xinxin现场介绍,「华为VR音视频平台」是华为终端云服务推出的全新内容平台,在全球各地,华为的用户都可以借助该平台随时随地进入表演现场,体验到最领先的音视听内容。

与VR音乐的立意相似,有一种职业,也是“一直在更具有临场感的声音之路不断探索”,那就是录音师。中国古典录音师制作人冯汉英在沟通会上谈到:“录音师最愿意做的事,就是把现场的沉浸感,无缝让大家在各种各样音箱设备中重放。”

声音的重放主要通过「音箱」和「耳机」实现。在音箱的重放部分,随着音频技术的不断发展,重放格式发生了巨大迭代,由单声道、立体声、平面环绕声,直到最近才逐渐兴起的沉浸式环绕声以及更加创新的VR音视频;而耳机的重放部分一直很不理想,因为只是通过音箱的信号来实现。

“华为VR音乐很大程度解决了传统音乐制作的痛点。”冯汉英说,比如与古典音乐结合,让更多人能感受到现场演奏的能量和生命力,这让音乐宫殿中的明珠再次绽放光彩。面对这一新的领域,音乐制作人也在探索新的音乐表现形式。

VR音视频平台:一个让更多人参与创作的连接平台

除了让更多人感受音乐现场,华为VR音乐还能为音乐公司、独立音乐人提供技术平台,包括高清VR视频采集与输出方案、VR摄影机、后期视频编解码及播放,为提升VR音乐创作的便利性、降低门槛。为了让更多人参与到VR音乐的创作生态中,华为计划未来把这种技术能力开放给内容开发者,共同推进VR行业的繁荣发展。

Xinxin介绍,VR音乐最独特优势即是沉浸感,还原现场的声音和物理特性,这对于建立沉浸感是极其重要的。华为在音频视频方面拥有自己的核心能力,除了还原现场的各种参数外;还通过13K*9K业界最高分辨率的3D VR视频,能同时保留高光细节和暗部色彩。

本次与严雯君等多位艺人的合作,都基于华为VR音视频平台,该平台为音乐产业人士提供了技术平台和一站式端到端的制作发行解决方案,包括前端播放能力、视频点播VOD服务、音乐开发工具及VR内容的制作与发行等。基于这样一个便捷高效、充满激励和创作活力的开放平台,内容创作者解决了从创作到制作输出的技术难题,能输出低成本、高质量、规模化的优质VR音乐内容,制作好的内容还可以直接登录华为云服务来发行,提供给全球用户来体验。

华为VR音视频平台的背后,源于华为很早提出的“以消费者为中心”、“软硬件双轮驱动”的全场景智慧生态战略。所谓“软硬件双轮驱动”,即一边不断落地“1+8+N”的硬件生态;另一边不断打磨操作系统、应用和服务生态。据悉,华为终端云服务(HMS-Huawei Mobils Services)已经为全球170多个国家和地区的7亿多用户提供数字服务。

2022年国内VR/AR市场规模将超千亿元,VR之势不可阻挡,华为VR音视频平台之势同样不容小觑。

好文章,需要你的鼓励

-

Queen's大学重磅研究:程序员的角色即将彻底改变,从码农到智能体指挥官

Queen's大学研究团队提出结构化智能体软件工程框架SASE,重新定义人机协作模式。该框架将程序员角色从代码编写者转变为AI团队指挥者,建立双向咨询机制和标准化文档系统,解决AI编程中的质量控制难题,为软件工程向智能化协作时代转型提供系统性解决方案。

-

医疗AI的"显微镜革命":西北工业大学团队发布首个超声影像专用智能助手EchoVLM

西北工业大学与中山大学合作开发了首个超声专用AI视觉语言模型EchoVLM,通过收集15家医院20万病例和147万超声图像,采用专家混合架构,实现了比通用AI模型准确率提升10分以上的突破。该系统能自动生成超声报告、进行诊断分析和回答专业问题,为医生提供智能辅助,推动医疗AI向专业化发展。

-

上海AI实验室突破自回归图像生成瓶颈:ST-AR让AI"先理解再创造"

上海AI实验室团队发现自回归图像生成模型存在局部依赖、语义不一致和空间不变性缺失三大问题,提出ST-AR训练方法。该方法通过掩码注意力、跨步骤对比学习和跨视角对比学习,让AI"先理解再生成"。实验显示,ST-AR将LlamaGen模型的图像理解准确率提升一倍以上,图像生成质量提升42-49%,为构建更智能的多模态AI系统开辟新路径。